Gh0st 对lsp 的诱惑

Gh0st 对lsp 的诱惑

【Rootkit 系列研究】序章:悬顶的达摩克利斯之剑

《序章:悬顶的达摩克利斯之剑》将着重介绍 Rootkit 技术发展历程、Rootkit背后的影子以及 Rootkit 检测基本思想,开启 Rootkit 系列篇章。

【应急响应专题】应急响应方法论

这是我自己对于应急响应归纳出来的方法论,一个笼统的、抽象的概念,包含思路和方法。

梦想cms二次注入漏洞分析

梦想cms二次注入漏洞分析

侧信道攻击之时序攻击(Time attack)

侧信道分析是一种新型的密码破解手段,其针对加密设备在运行过程中产生的时间消耗、功率消耗或电磁辐射等旁路信息进行分析达到攻击效果。

cms审计小结

审计了挺多的cms了,也有挖出不少的CNVD,幸运的是还申请了1个CVE编号,第一个编号总归是有些许激动的;这篇审计小结,就当做是自己审计经验的小小总结吧

Goland 代码审计: GitHub 开源项目 Crawlab

Goland 代码审计: GitHub 开源项目 Crawlab

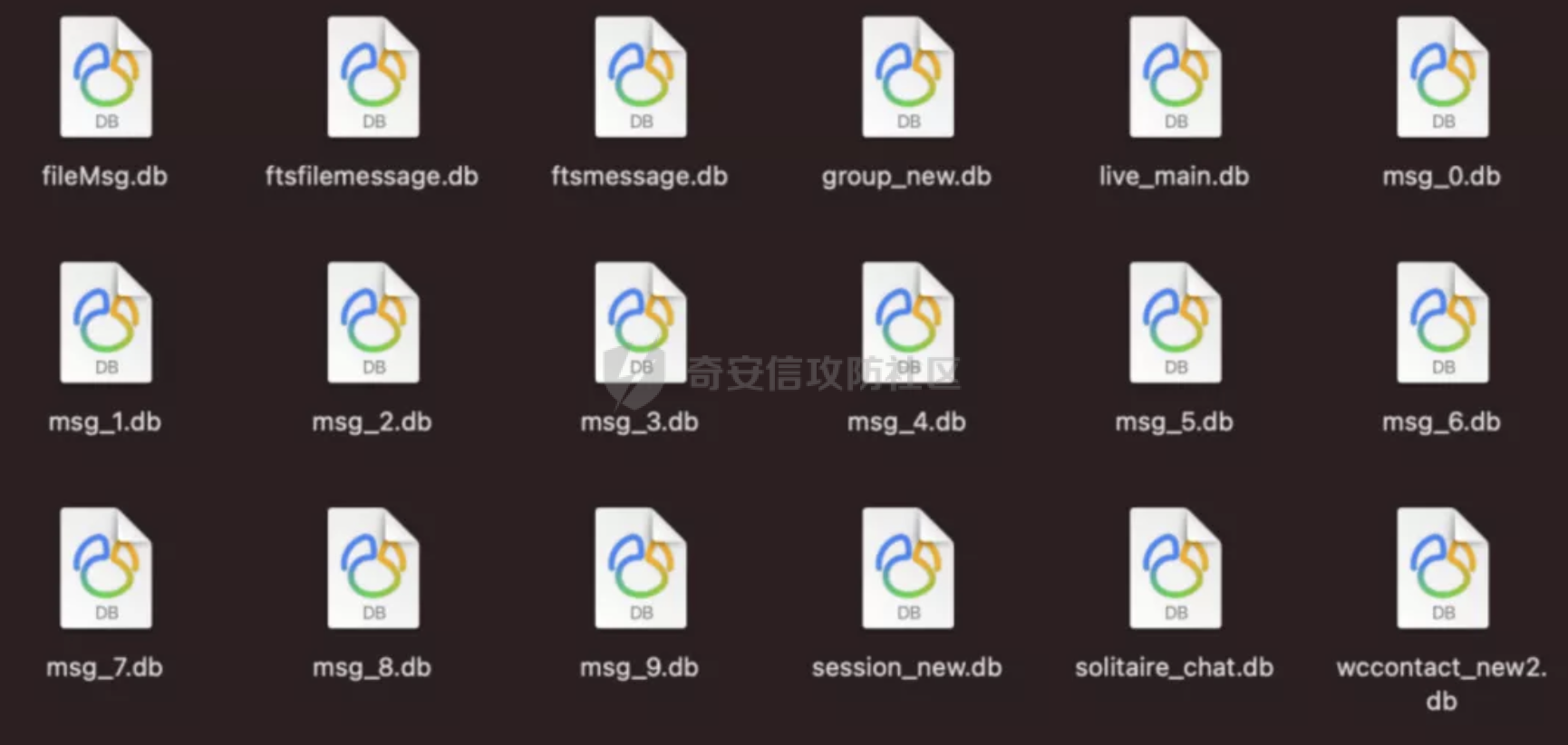

在mac os 中解密 WeChat DB

# 前提知识 先来了解一下有哪些DB 和 db对应的作用  这里主要会使用到msg_x.d...

CobaltStrike使用(域内渗透&横向扩展)

CobaltStrike使用-第六篇(域内渗透&横向扩展)本篇为CS使用系列第六篇文章,主要以一个案例来演示使用CS进行横向移动

SpringBlade框架JWT认证缺陷漏洞

SpringBlade框架JWT认证缺陷漏洞

从Apache Log4j2核武器级漏洞看服务器安全之痛

比漏洞本身更可怕的是「明知道有漏洞却防不住」。2021年注定是安全行业不太平的一年,除了0day满天飞、内存马&勒索病毒花式变形外,年末再曝彩蛋,Apache日志框架Log4j2爆出核武器级漏洞,简单总结一下,就是在日志打印时,如果内容中包含某一特殊字符,里面包含的内容可以被当做变量来进行替换,导致攻击者可以执行任意命令。

Apache Log4j远程代码执行漏洞(含排查措施和修复建议)

Apache Log4j是Apache的一个开源项目,Apache log4j2是Log4j的升级版本,我们可以控制日志信息输送的目的地为控制台、文件、GUI组件等,通过定义每一条日志信息的级别,能够更加细致地控制日志的生成过程。

线程同步的八种利用方法小结

分享者才是学习中最大的受益者!!

去除实名认证弹窗

## 前言 如今,网络游戏用户需使用有效身份证件进行实名认证,才可保证流畅体验游戏。本文对去除实名认证弹窗进行研究,仅供学习使用。 ## 实名认证弹窗 进入某手游,首先需要注册一个账号...

Go语言代码审计实战

java很卷,刚好周末有空,来看一下go,就写下了这个。

一次对PHP正则绕过的思考历程

## 一次对PHP正则绕过的思考历程 ## 0x0 前言 在某个CMS看到的一个基于正则的过滤函数,当时第一眼就觉得这种过滤其实没很大用的,后面深入地思考了一下,发现多种绕过思路,感觉还是...

某知名Java框架内存马挖掘

挖掘到了某知名Java Web框架的内存马,原理类似Tomcat的Filter内存马,通过这个经历也发现了一种进阶的内存马免杀思路

开源C2:Covenant学习

分享者才是学习中最大的受益者!

2021深育杯线上初赛官方WriteUp(PWN篇)

2021深育杯线上初赛官方WriteUp(PWN篇)

某CMS快乐审计

最近CMS审了好几个,根据CNVD上公布的试图去审出1day,但是效果却不太好,自己觉得能找到的可能的漏洞点到最后都利用失败了,本想着先暂时放放,但还是不太甘心,就又看了看,重新找了个CMS,经过一番战斗,终于算是有结果了。